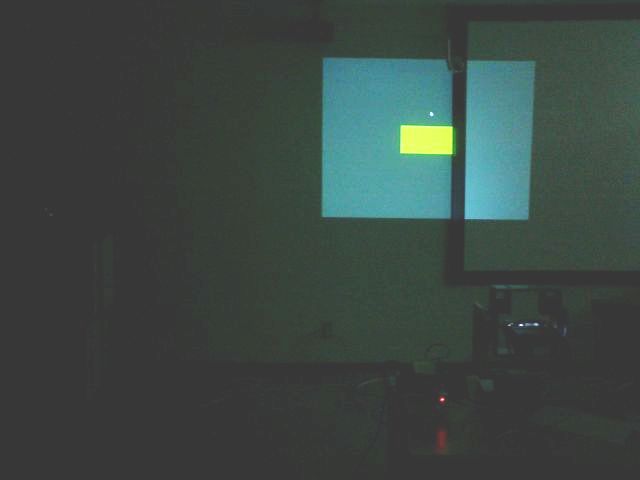

- 投影中心固定型パンチルトプロジェクタを用いた投影環境

- 実環境内におけるユーザへの視覚情報提示を行う複合現実感に関する研究が盛んです.

本グループでは,環境内の任意の平面に任意の画像情報を投影するために,

通常のプロジェクタにパン・チルト回転機構を持たせたパンチルトプロジェクタを開発しています.

このパンチルトプロジェクタを利用して視覚情報提示を行うためには,姿勢変化に起因する

投影画像歪みの除去,遮蔽物を回避した投影方法,複数台による投影分担方法など

多くの課題があります.本グループではこれらの課題を克服し,

表示したい場所に表示したい大きさ・形状の視覚情報を歪みなく投影できる環境の実現を

目指して研究を行っています.

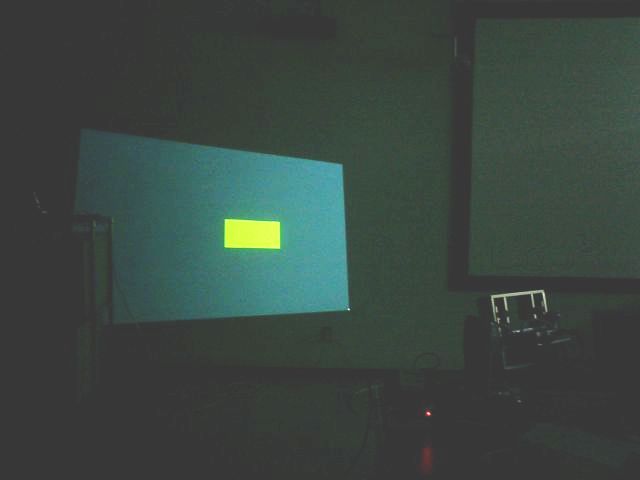

- 実環境内におけるユーザへの視覚情報提示を行う複合現実感に関する研究が盛んです.

本グループでは,環境内の任意の平面に任意の画像情報を投影するために,

通常のプロジェクタにパン・チルト回転機構を持たせたパンチルトプロジェクタを開発しています.

このパンチルトプロジェクタを利用して視覚情報提示を行うためには,姿勢変化に起因する

投影画像歪みの除去,遮蔽物を回避した投影方法,複数台による投影分担方法など

多くの課題があります.本グループではこれらの課題を克服し,

表示したい場所に表示したい大きさ・形状の視覚情報を歪みなく投影できる環境の実現を

目指して研究を行っています.

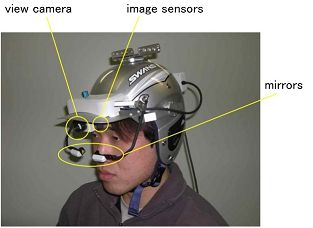

- ユーザ注視点の2次元・3次元位置推定

- 人間は常にその興味対象に意識的・無意識的に視線を向けており,視線情報は人間の意図を

非常に強く表している生体情報であると言えます.したがって,この視線情報を観測し上手に利用すれば,

人間にとって簡単で直感的なインタフェースを実現することができるだろうと考えています.

ここでは,ユーザの左右眼の視線方向とその頭部位置・姿勢情報を利用した,

注視点の2次元・3次元位置推定手法について研究を行っています.

またそれらの成果を利用し,ロボットの移動目的地を注視するだけでロボットを操作することのできる

アプリケーションの開発なども行っています.

- 人間は常にその興味対象に意識的・無意識的に視線を向けており,視線情報は人間の意図を

非常に強く表している生体情報であると言えます.したがって,この視線情報を観測し上手に利用すれば,

人間にとって簡単で直感的なインタフェースを実現することができるだろうと考えています.

ここでは,ユーザの左右眼の視線方向とその頭部位置・姿勢情報を利用した,

注視点の2次元・3次元位置推定手法について研究を行っています.

またそれらの成果を利用し,ロボットの移動目的地を注視するだけでロボットを操作することのできる

アプリケーションの開発なども行っています.

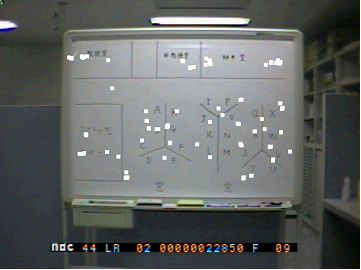

- 視野画像からの注視領域抽出

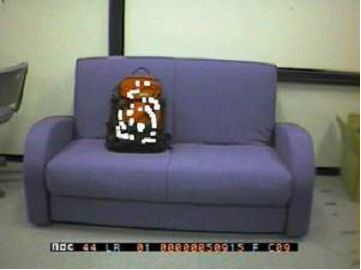

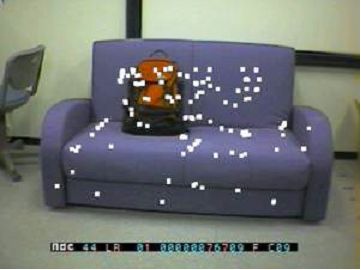

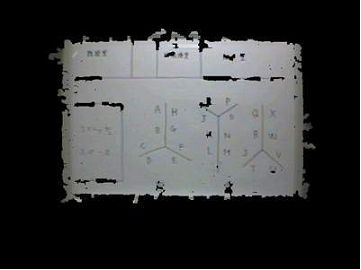

- 計算機システムが自動的に「人間がある瞬間に興味を持っている物体・イベント」を理解することができれば,その興味対象に関する情報をオンラインで提供することが可能になります.人間はほぼ常にその視線を興味対象に向けているため,人間の視野画像内における注視点系列を解析することにより,視野画像内から注視対象を抽出することができます.

下図は,人間の両目付近に取りつけた小型カメラによって観測された画像から注視領域を抽出した結果です.図中,人間の注視点集合が白点で示されており,人間の視線方向に応じて同じ画像からでも異なった領域が抽出できていることが確認できます.

↓ ↓ ↓ ↓

- 計算機システムが自動的に「人間がある瞬間に興味を持っている物体・イベント」を理解することができれば,その興味対象に関する情報をオンラインで提供することが可能になります.人間はほぼ常にその視線を興味対象に向けているため,人間の視野画像内における注視点系列を解析することにより,視野画像内から注視対象を抽出することができます.

下図は,人間の両目付近に取りつけた小型カメラによって観測された画像から注視領域を抽出した結果です.図中,人間の注視点集合が白点で示されており,人間の視線方向に応じて同じ画像からでも異なった領域が抽出できていることが確認できます.

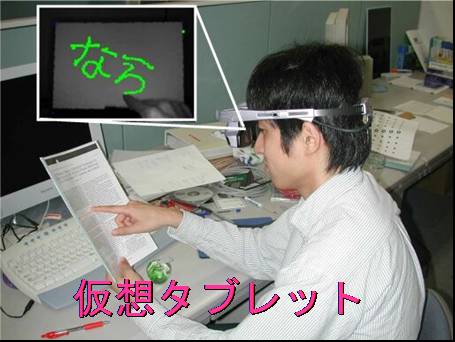

- ウェアラブル仮想タブレット

- 計算機の小型化にともない,いつでもどこでも利用できる計算機(モバイルPC,ウェアラブルPC)が現れていますが,従来のデスクトップPC環境での使用に適したキーボードやマウスなどの入力インタフェースをそのままいつでもどこでも使用することは難しいです.そこで我々は,小型CCDカメラとヘッドマウントディスプレイ(HMD)を着用し,身近にあるノートやバインダなどの四角い平面状の物体を手に持ち,その表面を指先でなぞることによって絵や文字など任意のコンテンツが入力可能なインタフェースシステムの研究・開発を行っています.

また,使用環境や使用条件に応じて適切なカメラデバイスもそれぞれ異なるため,各条件に適したカメラデバイスを使用しています(例:ステレオビジョンカメラ,赤外線照射カメラなど).

- 計算機の小型化にともない,いつでもどこでも利用できる計算機(モバイルPC,ウェアラブルPC)が現れていますが,従来のデスクトップPC環境での使用に適したキーボードやマウスなどの入力インタフェースをそのままいつでもどこでも使用することは難しいです.そこで我々は,小型CCDカメラとヘッドマウントディスプレイ(HMD)を着用し,身近にあるノートやバインダなどの四角い平面状の物体を手に持ち,その表面を指先でなぞることによって絵や文字など任意のコンテンツが入力可能なインタフェースシステムの研究・開発を行っています.

また,使用環境や使用条件に応じて適切なカメラデバイスもそれぞれ異なるため,各条件に適したカメラデバイスを使用しています(例:ステレオビジョンカメラ,赤外線照射カメラなど).